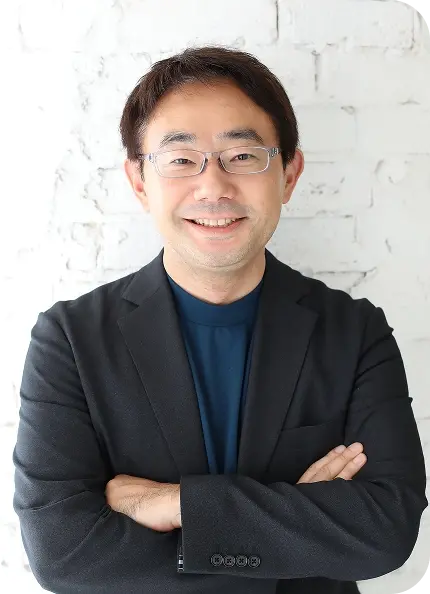

武蔵大学 社会学部 メディア社会学科 准教授

宇田川 敦史 氏

PROFILE

1977年東京都生まれ。武蔵大学社会学部メディア社会学科准教授。東京大学大学院学際情報学府博士後期課程修了。博士(学際情報学)。京都大学総合人間学部卒。

メディア研究者。専門はデジタル・メディア論、メディア・リテラシー、メディア・デザイン。

京都大学総合人間学部を卒業後、日本IBMにてWebシステムの設計・開発に携わる。その後楽天株式会社にてデジタル・マーケティング、SEO、UXデザインに従事したのち現職。デジタル・プラットフォームにおけるアルゴリズムの社会的なあり方について、メディア論・メディア史の視座から研究を行っている。また、アルゴリズムのようなメディアの「仕組み」に着目したメディア・リテラシーの育成プログラムの開発にも取り組んでいる。

主な著書に『アルゴリズム・AIを疑う: 誰がブラックボックスをつくるのか』(集英社、2025年)、『Google SEOのメディア論: 検索エンジン・アルゴリズムの変容を追う』(青弓社、2025年)、『AI時代を生き抜くデジタル・メディア論』(北樹出版、2024年)、主な論文に「検索プラットフォームと「AI」のダイナミクス」(『メディア研究』106号所収、2025年)などがある。

『アルゴリズム・AIを疑う: 誰がブラックボックスをつくるのか』(著者:宇田川敦史、発行:集英社)

01

情報の非対称性をどう捉えるかを研究テーマとする

―今回は、宇田川先生のご著書『アルゴリズム・AIを疑う 誰がブラックボックスをつくるのか』(集英社新書)のご紹介も含めて、その内容に沿った形でお話をお聞かせいただければと思っています。では、早速始めさせていただきます。まず、宇田川先生の研究テーマから、ご紹介いただけますか。

私は、元々日本IBM でエンジニアとしてWeb開発を手掛けていました。その後、楽天というプラットフォームの中でマーケティングの仕事をしていました。私自身はいわゆるデジタル・マーケティングやUX (ユーザーエクスペリエンス)デザインの領域をプラットフォームの中で実務家として取り組んできたのですが、さまざまな限界を感じていたと言うことが、まず背景になります。

その限界と言うのは、ご承知の通り、もう10年以上前から続く「クリック至上主義」でした。コンバージョンレート(Webサイトへの訪問者のうち、購入や申し込みなどの成果につながっている割合を数値化したもの)をいかに上げるかに、現場は一生懸命頑張るものの、その頑張りというのが社会全体で見たときに、本当に価値を生み出しているのかどうかよくわからないというジレンマがありました。

例えば当時の楽天では、メルマガを大量に打っていました。メルマガは基本的に配信の単価が極めて安いので、コンバージョンレートが多少低くても多く配信した方が儲かるという構造があるわけです。ユーザーから見ると要らないメルマガが大量に送られてきて困ってしまうことになります。「この矛盾は何なのだろう」ということが、私自身が研究者への転身を考え、そういった勉強を始めたきっかけでした。

プラットフォーム企業の外部の視点から、テクノロジーを提供する側の立場を相対化してみると、ユーザーから見えている姿と、それを実際に運営する側の論理に大きな「情報の非対称性」(取引主体間において情報や知識の量・質に格差がある状態)があることがわかってきました。その情報の非対称性をどのように捉えられるのかというところが、一番大きな研究の関心になります。

このような問いは、学術的にはメディア論やメディア・リテラシー論の問いにつながります。メディア、あるいはプラットフォームを一つの切り口にして、そこで流通する情報を見ていくある種の「リテラシー」は、ただ単に嘘を見破るとか、批判的に読むとか、そういうことだけではなく、そのメディアの持つ内部的な仕組みであったり、送り手の都合、経済・産業的な状況とか、そういった構造的な矛盾も含めて考えていく必要があるという関心から研究に取り組んでいます。

02

プラットフォームでの実務経験を通じてさまざまな限界や矛盾を感じる

―ありがとうございます。宇田川先生は日本IBM に入社されて、その後楽天に転職されるなど、実務者を経験された後に研究者になられました。楽天にいらしたときにメール配信などでの、ある意味矛盾に気づかれて、研究者に転身されたということなのですね。

そうですね。その矛盾の根本は、大きな意味で言うと資本主義の構造的な問題ということになります。最近では「プラットフォーム資本主義(プラットフォームを介してデータを収集・活用し、企業が利益を最大化していく経済モデル)」という言葉もあります。数字だけを追い求めるようなビジネスのやり方をしていたときに、それが本当に顧客やユーザーのためになっているのかということは、企業の仕組みの内部の視点からだと分からなかったりします。中長期的に見れば、最終的にはやはりユーザーのロイヤルティや生涯価値は考えなければいけない課題ですし、それは企業が社会にどういう価値貢献をしているのか、という問題ともつながります。ただ、どうしても企業は短期的な利益に縛られるので、そういう構造的な問題に取り組むためには、企業の中にいるだけだと限界があるというのが、私の原点です。

―宇田川先生が、今回の著書を執筆しようと思われたのは、楽天にいらっしゃるときだったのですか。それとも研究者になられてからですか。

具体化したのは、研究者になってからです。集英社さんの編集担当の方からお話しをいただいて、企画として立ち上がったものになります。ただ、構想としては元々実務家時代から書きたかったことがあったので、それを集英社の方と企画の中で練り上げてきたという感じです。

03

エコーチェンバー状態が相互作用を起こしている

―今までは、実務者としての課題や問題意識を持たれていたと思います。研究者になられて、研究の現場での課題に接せられることはありますか。例えば、社会的な危機意識や世論の変化を感じられた場面があったりしましたか。私は、宇田川先生の著書を拝読して、エコーチェンバー(ユーザーが自分の興味や意見に合った情報だけを受け取り、他の意見や思想を排除する傾向)が非常にクリティカルな問題ではないかと思いました。昨年の参議院選挙でもSNS を使って対照的なポリシーを植え付ける政党があり、結果的に X (旧ツィッター)だったり、他のSNSとか、同じようなものを見たらそればかりレコメンドしていました。そうするとメディアリテラシー(メディアの特性を理解し、メディアが発信する情報を主体的に読み解き、評価・吟味する能力)がなかったら、「皆同じことを考えているんだな」と思ってしまいます。

そうですね。それは、研究者の現場の課題というよりは、社会全体の課題として、まさにメディアの持つ問題がクリアーに出てくるようになって来たという感覚はあります。

エコーチェンバーやフィルターバブル(インターネット上に膨大な情報やデータがあるにも関わらず、見るものが自分の興味や信念に囲まれてしまう状態)は、やはり非常に大きな問題です。それが厄介なのは、そのような現象があること自体は、一般にも知られつつあるにも関わらず、普段の情報接触の中で常にそのことを意識できるかというと、なかなか難しいという点です。それは、メディアの構造的な問題であると同時に、人間の認知、あるいは心理的な傾向との兼ね合いの問題でもあります。いわゆる認知バイアス(人間の思考や判断に影響を与える非合理的な傾向)というものによって、どうしても自分の好みの情報だけが目に入ってくるようになります。そういう心理的傾向と、エコーチェンバー状態が、相互作用を起こして、世の中にある情報の分布が正しく認識されず、自分が考えている社会の像と実際の社会の像との間でどんどん乖離が拡大していくという状況が、非常に問題だと思います。

民主主義の基本というのは、社会全体の状況を個々人が認識できることにあります。たとえばあるマイノリティの人たちが、こういう割合で社会の中で困っていると正しく認識するというのは、資源の再配分を考えたときに非常に重要です。ただ、それがかなり難しい状況になってきているし、それができていないことを自覚できない状況になっています。

04

複雑化するメディア環境。疑う力が問われている

―面白い問い方ですね。どんどん加速しているような気がします。それが、やはりメディア・リテラシーや情報リテラシー(情報を適切に読み取り、信頼できる情報のみを正しく活用する力)が高い人は、もちろん批判的に物事を見るようにしていると思います。しかし、ある意味、多くの方がそういった批判的な物事の見方をしていない傾向があります。

宇田川先生、今回書籍のタイトルに「疑う」という言葉も使われています。この「疑う」という言葉を前面に出されたというのは、やはり問題意識として情報リテラシーを持たない人が多いから、しっかりと批判的に見ないといけないという提言だったのですか。AIを疑う、アルゴリズムを疑うというのは、結構センセーショナルなタイトルだと思います。いかがですか。

「メディア・リテラシー」という考え方自体は、急に出てきたものではなくて、元をたどれば第二次世界大戦後にメディアがプロパガンダ(特定の意見や信念を広めるための情報操作)の片棒を担いではいけないという反省と呼応する形で始まっているものです。批判的思考、クリティカルシンキングは、そういうところとつながっています。

そういった歴史的な経緯のある「疑う力」を、複雑化するメディア環境の中でしっかり考え直す必要があるだろうということが、このタイトルに込めた意味です。ただ、これは非常に難しい問題です。疑うということ自体が難しいということもあるのですが、疑うというのは、態度を決め切らないということでもあります。

これに関して、面白い調査があります。国際大学グローバル・コミュニケーションセンターの山口真一さんらの研究グループが行った調査なのですが、「自分には疑う力がある」と思っている人、例えば、メディア・リテラシーについて教育を受けて「自分は批判的思考を身に着けた」と思っていると自己申告した人ほど、実際には偽・誤情報を拡散している傾向があるというのです。自分はメディア・リテラシーがあって、情報の偏りのことをわかっているし、SNSに騙されていないという自己認識がある人の方が、実は陰謀論であったり、偽・誤情報に気づきにくいという調査結果もあるのです。

つまり、自分自身の力を疑えていないのです。それを疑うのは結構辛いことで、厳密には「結論を出せない」という状態を白黒つけずに耐えなければいけないことも多い。そういう意味で疑った結果検証できないものを保留するという、深い意味での批判的思考が実は必要なのです。このように、批判的にものを考えるというのは、ある種判断を保留するであったり、根拠がないものに対して根拠がないまま耐えるというようなことも含めて考えなければいけないことだと思っています。このような水準の疑う力は、AIが普及する社会で特に重要になってくるでしょう。

05

機械学習や深層学習での出力は、ルールベースではない

―宇田川先生の著書を読ませていただくと、その点が非常に丁寧に書かれていると感じました。その中で、第1章でアルゴリズムとは何かという定義とAI との関係というところが、中々難しい結びつきだと思います。AI とアルゴリズムの関係性に関して、核となる考え方は何かありますか。お持ちであれば教えてください。アルゴリズムは、どうしてもロジカルに、ある程度人が考えた内容で組み立てていくということだと思います。AI の場合は、そこはアンコントロールなところで、ある程度深層学習で自動的に特徴を出しながら自己判断していくことになってきます。宇田川先生の言葉でこの核となる考えをお聞かせいただきたいのです。

「アルゴリズムとAIの境界線をどこに置くか」というのは、諸説あると思います。AI もアルゴリズムだと言う人もおり、色々な立場があると思っています。ただ、私はやはり機械学習に基づくニューラルネットワーク(人間の脳の働きを模倣した AI 技術)を使ったAIは、既存のアルゴリズムという考え方とは根本的に違う基礎を持っていると思います。

最近使われる言葉で言うとルールベース(設定したルールに基づいて問題を解決するアプローチ)であるということが、アルゴリズムの基本的な性質でありAIとの違いです。パラメーターであったり、ロジックであったり、事前定義されたルールの部分ですね。エンジニアなり、設計者なりが、まさにプログラミング言語で書かれうるもの、言語化可能なものとして定義されているものをアルゴリズムと呼ぶべきだろうと思います。

機械学習や深層学習で何らかの出力をするというような分類器、あるいは生成器のような近年のAIの仕組みは、その中身がそもそもルールベースではないので、一定のパラメーターに対して必ず同じ出力がなされる保証がなく、根本的に違うものだと考えた方が良いのではないかというのが、この本でも書いたことです。いわゆる技術的なブラックボックスとして、人間がその中身を確認できないという点が、原理的な違いです。

06

ますますアンコートローラブルな領域に入り込んでいく

―おっしゃる通りですね。アルゴリズムは本当に設計者が インプットをすればアウトプットが確実に返ってくるので、ある意味恣意的に変えることができる、言わばコントロールできるものです。他方、マシンラーニングや深層のディープラーニングは、ある程度もうアンコントロールな領域に入って来ています。さらに、超知能(ASI:人間の知性を超えるAI)みたいなものが今後出てくると、人はもう想像がつかない領域に入っていくような限界点とかに来ているのではないかと思います。この辺り、宇田川先生はどうお考えになりますか。

「超知能」みたいな言い方は、人によってすごく多義的というか、何を指しているかよく分からないところがあります。「シンギュラリティ(技術的特異点:AIが人間の知能を凌駕し、技術が指数関数的に発展すること)」もそうです。いわゆる汎用 AI (人間とほぼ同じように幅広い知的活動をこなせるAI)、という言葉自体の指す意味が変わりつつあるというのが、今まさに起きていることだと思います。数年前に言われていたシンギュラリティの話には、AI がそれこそドラえもんみたいな自意識をもって、人間と同じように振る舞い、感情をもつことも含めて、ある種の夢物語的なものとして捉えられてきた世界観があったと思います。そういう意味での、汎用 AI というか、超 AI(人間の知能を凌駕した知的範囲を有するAIシステム) のようなものは、今の技術の延長にはないというのは、変わらない事実だと思います。現在の深層学習に基づくAIが意識をもつようになることは、原理的にも考えにくいです。

―私も、そう思います。超知能と言われるものは、やはりある程度、もう AI 自身が自ら考え行動するようになる世界だろうなと。まだそこまではいかないと思います。まあ、AGI(汎用型人工知能) のレベルが多分近い将来来て、その辺りどうなのかと思いますけれど。ただ、予想がつかないというのが今、正直な気持ちです。宇田川先生は、研究者から見て、将来どうなるかという予測がつきますか。

全く予測がつかないですね。つかないというよりは、予測がますます難しくなるという変化が今まさに起きています。つまり、先ほどおっしゃっていたそのコントローラブルな領域がどんどん減って来ていることが、まさに、予測が困難になっていくことと表裏一体だと思います。

アンコントローラブルであると言うことは、もはや先ほどお話ししたインプット、アウトプットの関係が成り立たないということです。通常の生成AIに何か聞いたとして、同じプロンプトを入れたとしても同じものが出てくるとは限らず、モデルもどんどん変わるし、結局それを何らかの業務プロセスに落とし込んだときに、同じプロンプトを使っていたとしても、その時その時でアウトプットも変わってくるような状況がありうるということです。ただそのアウトプットは恐らく的外れになっていくというわけではなく、より適切なというか、エンドユーザーが求める方向に調整されるようなものだと思いますが。

そうすると、もともとプロンプトを入れるなり、それを設計している側のサービスを提供している人たちが、なぜそのユーザーが満足できているのかということに対して、何も説明できないという状況や領域がどんどん広がっていきます。それが結局なぜだかわからないけれど、最適化されているという状況が遍在化したときが、当初の想定とは違う意味でのある種の「超AI」の出現だと認識すべき社会になっていくのだろうと思います。そして恐らく、それは止められない方向だと思っています。

07

集合知だから正しいは思い込みにすぎない

―先般インタビューをさせていただいた、一橋大学の小町守先生は説明できるAI(機械学習アルゴリズムによって生み出されたAIの判断根拠を人間が理解・信頼できる形で説明する手法)について語っておられました。非常に面白いと思って、お話を聞いていました。ただ、実際にはどんどん説明できないような AI の領域に来ているという気がします。

次に二章のお話をさせてください。この章では、Google のランキングやアマゾンのレコメンド、食べログのスコアリング、X のタイムラインなど表示のことを扱われています。それらをどうして取り上げられたのかが気になりました。私は食べログのスコアリングを見て、それを信じてしまうところもあります。また、今は GoogleよりもChatGPT に聞いた方が早かったりすると思います。X はまだですが、食べログは結構信頼度が上がってきたと感じています。宇田川先生はそこに対して問題意識を持たれているということですか。

そうですね。私自身は実務で比較的 SEO(検索エンジン最適化) を長くやってきた人間です。SEOの興味深いところは、広告ではなくて「ナチュラル」な検索結果を操作しようとする試みだということです。「ナチュラル」であるということは「自然検索」とも言われますが、上の方に出てくるものは、何か信頼性があるものだとか、正しいものだという幻想をユーザーが勝手に抱いてくれるような意味を含んでいます。つまり、そこにはある種のマジックがあるわけです。

しかし、実際には SEO を一生懸命頑張っている人たちがいて、その結果として検索結果の順位は常に変動しますし、Google のアルゴリズムのさじ加減次第で上の方に出てくるものが変わっています。問題のあるコンテンツが上位に出てしまうみたいなことも含めて、ユーザーが勝手に思い込んでいるほど信頼性が高いわけではないのです。アルゴリズムというコントローラブルな、ある種のルールベースの何かによって出力された結果としてそれが起きているわけですが、その背景にはそこに介入しようとするSEOの活動と、関連性を高めようとするGoogleの間の相互作用があるわけです。

そういう現実を自分も経験してきた中で、集合知(多様な知識が結集したもの)だから、「何となく正しいだろう」というユーザー側の思い込みや期待みたいなものに対して、それを無批判に受け入れるべきではないというのが、私が書きたかったことの一つです。

08

プラットフォーマーを完全否定するのも極端な考え

―集合知でいう民主的な考えからすると正しいと判断すると思うのですが、プラットフォーマーである食べログもかなり努力をしています。実際、投稿者の信頼度も見ています。なので、お金をもらって投稿しているような人たちはものすごく低スコアになって、上げられなくなっていたりしています。やはり、プラットフォーマーとして結構倫理面はしっかり守られていると思う一方で、提供側のプラットフォーマーがそこを少しでも自己に有利とか、もしくは何らかの操作をするなら、もうアウトですよね。

そうですね。その辺りはまさに非常に微妙なバランスです。こういったサービスがアルゴリズムやパラメーターの非常に細かい調整によって実は成り立っているということ自体、恐らくエンドユーザーの方々はあまり意識されていないですし、知らない方も多いだろうと思います。だから、メディアに対する認識は両極端になりがちなのです。

一方では、「集合知だから、信じて良いんだよね」と。たとえば食べログの点数は、もう集合的な投票によって計算で決まっているのだから、「これが客観的なんだよね」って、それを明言しないまでも何となくそう思っているユーザーがいます。もう一方では、こんなのはプラットフォーマーが自己都合で勝手に決めていて、全然信用できないし、「一切信頼してはダメなんだ」みたいな、完全に否定するようなユーザーもいるわけです。後者はもしかしたらメディア・リテラシーがあると思っている「批判的なものの見方を身につけた」人たちかもしれません。そうした両極端なものの見方があって、現実はそのどちらでもないということをしっかりと伝えたいという想いがありました。特に私の場合は、プラットフォームの中の人でもありながら、外からも見ることでその矛盾に気づくようになった立場だからこそ、そのバランスをとることが重要だと痛感しています。

09

多くの社会問題はアテンション・エコノミーに結びついている

―これまでは、食べログにしても、Amazonのレコメンドも、GOOGLEのランキングでもありました。LLM(大規模言語モデル)が出て来たことによって、今後どんどんブラックボックス化していくのではないですか。そうするとよりわかりにくくなってくる世界が来ているのではないかと思います。

第3章でアルゴリズムと社会問題を取り上げられていて、特に私が印象に残ったのはアテンション・エコノミー(注目状況:高度情報過多の社会で、情報の優劣や情報量に比してアテンションが希少となる経済モデル)や情報分断、偽情報の拡散、そのシステムとかもあったりするのですが、ユーザーの商品化というか、インフルエンサーとか色々な人たちがいて、その人たちの影響力があったり、インスタグラムを見ていると、それこそ詐欺まがいの商品を売っていたりして、それを拡散して売って逃げてしまうという動きがあります。宇田川先生はこのアルゴリズムと社会問題との結びつきに関して、どこを一番重視されていますか。色々とテーマがあったと思うのですが。

基本的に今起きている色々な社会問題は、ほとんどがアテンション・エコノミーに結びついていると思っています。いわゆるアテンション・エコノミーを遡れば、情報オーバーロードにたどり着きます。情報が非常に過多になっているし、流通する情報量は増え続ける一方、あらゆるユーザーが情報を発信できる状態です。それをアテンション・エコノミーの論理でフィルタリングをして、ユーザーにとって認知可能な状態に整えるというのが、その間にあるアルゴリズムであったり、AIが果たしている役割です。

結局そういった間に入るプラットフォーマーが拠って立つところが、アテンション・エコノミーになってしまっているということは、インセンティブとして、ユーザーに正しい情報を届けるとか、信頼性があるものを届けることよりも、より注意を引く、アテンションを集める、クリックされる、PVが稼げるという方向に構造的になってしまうことが、偽・誤情報を含めた色々な問題の原因につながっていると考えています。